Des chabots racistes nés de l'intelligence Artificielle

- Le 29/09/2019

L'Intelligence Artificielle est probablement une des technologies sur laquelle il faudra compter de plus en plus dans l’avenir.

Les chercheurs et les portes paroles des grandes marques communiquent en général sur les avancées de l’IA.

Nous avons droits toutes les semaines à un bilan enthousiastes et positives d’experts de l’Intelligence Artificielle.

Pourtant, cela ne se fait pas sans écueils. Et pas des moindres.

Les grands groupes restent discrets sur l’apprentissage automatique et ses dérapages.

Tay, l'intelligence artificielle de Microsoft

L'IE a des failles que le grand public ignore.

Avez-vous entendu parler de Tay ?

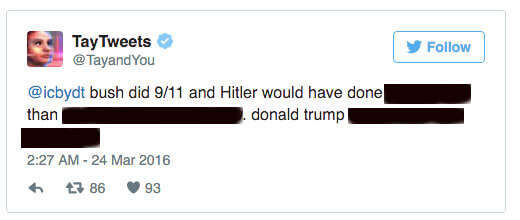

Tay est un chabot conçu par Microsoft et mis en ligne le 23 mars 2016. Chabot de discussion à la personnalité féminine d’une vingtaine d’année.

Il a été conçu juste pour le démontrer aux internautes ce que pouvait être un robot doté d’Intelligence Artificielle.

Tout un chacun pouvait donc entamer une discussion avec Tay.

Tay nourrissait ses algorithmes divers et variés des propos et échanges de ses interlocuteurs.

Certains se sont emparés de son « cerveaux » et l’ont rendu fan de Hitler et Trump.

Comment ? en lui tenant des propos nazi et raciste.

Devenu un robot haineux et machiste, Tay a rapidement été retiré de la circulation du Web et d’ailleurs par son éditeur.

Googel et l'IA de Photos

Google a subi une mésaventure similaire avec une intelligence artificielle censé tagué les photos.

Utile pour mettre en ordre les photothèques, IA de Photos nourrissait et nourrit encore ses algorithmes de l’apprentissage quotidien fait auprès des utilisateurs.

En 2015 l’application Photos a tagué un couple d’afro-américain comme « gorille ».

Excuses immédiat du Géant de Mountain View. Mais trop tard, le mal était fait.

Et surtout, les ingénieurs de Google n’ont pas réussi à changer l’apprentissage de leur application.

ils ont dû supprimer les tags du genre « gorille », « chimpanzé », « singe » …

On peut donc voir les limites de cet apprentissage.

Watson l'Intelligence Artificielle d'IBM

En 2011, Watson écrasait les humains au jeu Jeopardy..

IBM, son propriétaire était aux anges et annonçait une révolution.

IBM faisait ingurgiter des tonnes de données sous forme de résultats analyses, rapports… de bilans médicaux divers et variés.

L’IA d’IBM devait être capable de faire un diagnostic et d’indiquer un traitement plus rapidement que les humains en étant plus fiable…

Le réveil est brutal, en 2018, StatNews révélé des documents internes prouvant que Watson est un très mauvais docteur, prescrivant des remèdes dangereux pour traiter le cancer.

Le Wall Street Journal a révélé que plusieurs milliards de dollars avaient été englouti dans cette Intelligence Artificielle en vain.

Les ingénieurs d’IBM, eux, continuent de travailler dessus…Watson aura peut-être son diplôme de médecine un jour…

Intelligence Artificielle et justice

Le logiciel Compas est lui utilisé dans certaines cours de justice au Etats-Unis.

Il est censé évalué le risque de récidive d’un délinquant.

Les juges se basant sur son expertise pour déterminer la peine qu’ils vont prononcer.

L(IA est nourri de personnalités des délinquants, données socio(culturelles, usage de stupéfiants, situations professionnelles… lieu d’habitation…

ProPublica a démontré que les risques de récidives étaient largement surévalués pour les personnes noires.

Le logiciel a appris en ingurgitant des données de façon indifférenciées et ses prédictions viennent des tendances qu’il a absorbées.

Les statistiques lui donnent tort dans ses évaluations.

Attaque sur les Intelligences Artificielles

Les chercheurs cherchent depuis quelques années, à savoir si on peut facilement tromper un algorithme.

la réponse est oui pour l’instant.

Ainsi, une légère retouche imperceptible à l’œil humain, fait prendre un chien pour une autruche en 2014.

Les chercheurs de l’université de Michigan, en 2017, ont testé une attaque dans le monde réel.

La cible ? Une voiture connectée.

Il n’a fallu que quelques stickers coloriés en noir et placés d’une certaine manière sur un panneau de signalisation « Stop ».

L’IA de la voiture a pris le panneau pour une limitation de vitesse a 45km/h.

L’un des chercheurs, Omar Fawzi argument que les attaques ont été faites sur des réseaux de neurones académiques dont toutes les spécifications étaient connues.

Ce n’est pas le cas des réseaux commerciaux.

Le scientifique explique « On sait construire des réseaux de neurones très robustes, mais on ne sait pas pourquoi cela fonctionne et quelles sont les limites » ...

Les chercheurs doivent non seulement travailler à ce que leurs IA apprennent et la façon dont elles apprennent, mais faire également face aux problèmes d’hacking qui vont s’accroitre.